Что такое объяснимый ИИ и что он значит для вас?

По мере того, как предприятия расширяют использование искусственного интеллекта (ИИ) для оптимизации своих операций, а люди все больше внедряют инструменты ИИ в свою повседневную жизнь, становится необходимым понять, как ИИ принимает решения. Объяснимый искусственный интеллект (XAI) позволяет людям понять обоснование систем ИИ и процесс принятия решений, что может помочь укрепить доверие. Обычные системы ИИ довольно продвинуты и способны решать сложные задачи, но процессы принятия решений часто скрыты от пользователей и заинтересованных сторон.

Недостаток видимости может вызвать недоверие, поскольку люди не могут понять, как работает система или почему она приняла те или иные решения. ИИ окружает нас в повседневной жизни; это больше не концепция будущего. ИИ также проник в нашу экономику, потенциально способствуя К 2030 году объем производства увеличится на 13 триллионов долларов США. В этой статье мы обсудим, почему объяснимость ИИ необходима и что она означает для вас.

Когда его спросили, как должен выглядеть объяснимый ИИ, это то, что сгенерировало Midjourney.

Когда его спросили, как должен выглядеть объяснимый ИИ, это то, что сгенерировало Midjourney.Что такое объяснимый искусственный интеллект?

Объяснимый ИИ — это форма ИИ, предназначенная для объяснения того, почему он принимает собственные решения. Вместо вывода XAI предоставляет интерактивные объяснения того, как он работает, и делает выводы. Это помогает специалистам по ИИ понять смысл систем ИИ и повышает доверие к их решениям.

Модель XAI использует обработку естественного языка и графики знаний, чтобы объяснить, как были приняты решения, которые используются для сравнения прогнозов модели и производительности в различных областях, от здравоохранения до финансов. Алгоритмы XAI сочетаются с традиционными моделями ИИ для раскрытия логики; это важный шаг к ответственному ИИ, который помогает повысить прозрачность искусственного интеллекта.

Итак, что все это значит для вас? XAI может создать более прозрачный и подотчетный мир, и вы можете доверять своим системам искусственного интеллекта в принятии справедливых и ответственных решений. Прозрачность облегчает организациям внедрение автономных систем в свою деятельность, поскольку они могут объяснить обоснование своего выбора. Это также позволяет людям уверенно использовать инструменты ИИ, зная, что система заслуживает доверия.

Как работает объяснимый ИИ?

XAI позволяет ответственно использовать ИИ, объясняя его решения, анализируя вопросы справедливости/дискриминации и обеспечивая большую ясность. На базовом уровне системы объяснимого ИИ используют НЛП и графы знаний, чтобы оптимизировать производительность модели и разбить сложную модель на более понятные концепции. Не из-за отсутствия попыток, но обычный человек вряд ли разберется в системах обработки нейронной информации. Вместо этого давайте обсудим, что входит в систему объяснимого ИИ.

Что включает в себя система ИИ в объяснимом ИИ?

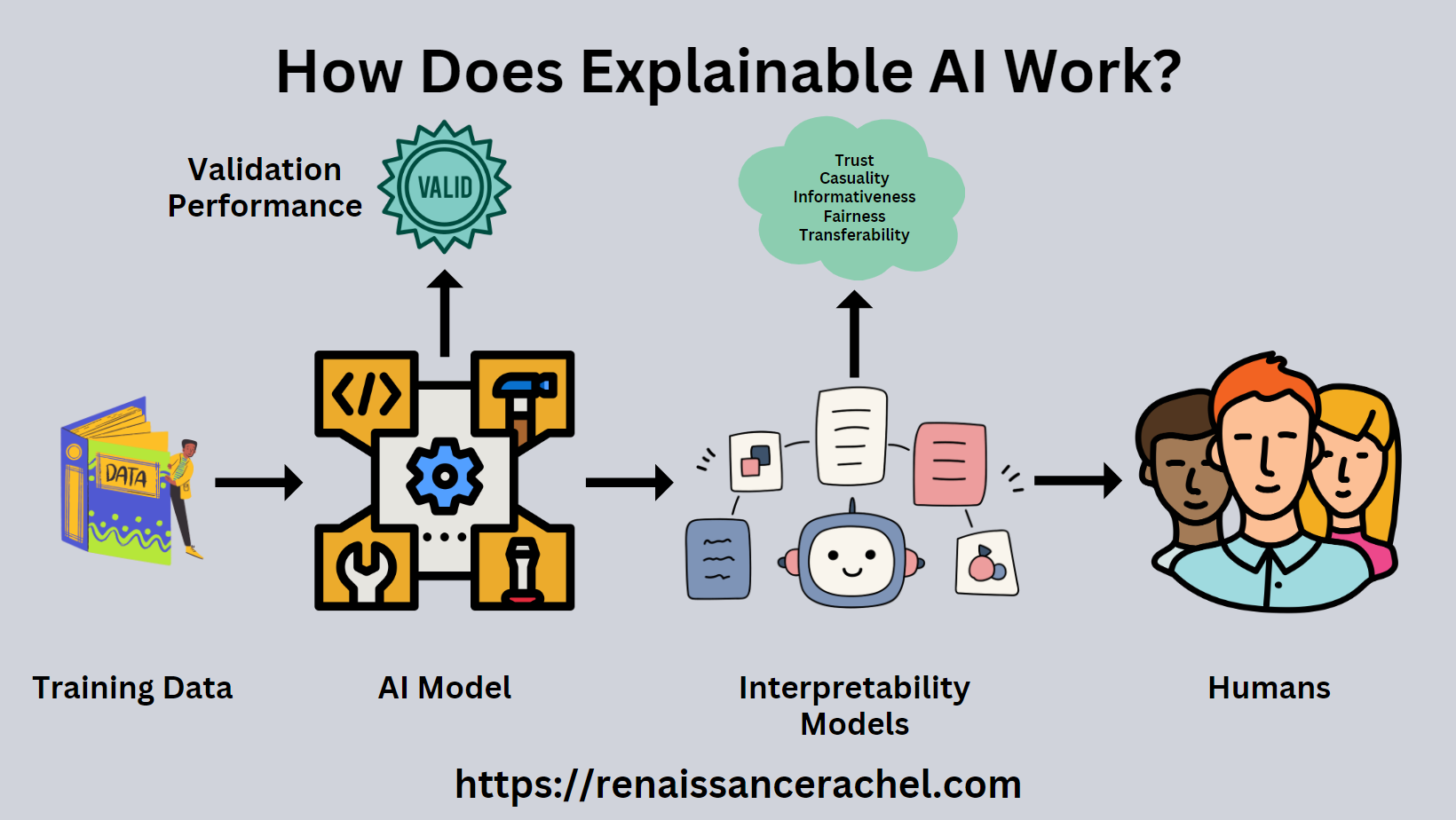

Система объяснимого ИИ включает четыре основных компонента: данные, модели ИИ, концепции интерпретируемости и пользователи-люди. Концепции интерпретируемости — это набор правил и алгоритмов, которые показывают процесс принятия решений модели ИИ. Другими словами, концепции интерпретируемости помогают любому понять, что изучают модели и что они могут вам предложить.

Данные

Компонент данных в объяснимом ИИ относится к обширной информации, которую эти системы ИИ интерпретируют. Эти данные включают в себя все, что угодно, от моделей поведения клиентов до сложных бизнес-показателей. Ключевым моментом здесь является то, что объяснимый ИИ не просто обрабатывает числа; он дает представление о том, почему на основе данных были сделаны конкретные рекомендации.

Это похоже на супер-умного аналитика, который не просто передает вам электронную таблицу, а проводит вас по данным, выделяя важные тенденции. Это облегчает компаниям и частным лицам понимание результатов ИИ и доверие к ним, что приводит к более эффективному принятию решений. Наиболее достижимая категория XAI — «объяснимые» данные.

Модели ИИ

Компонент алгоритма ИИ в объяснимом ИИ — это мозг системы; именно здесь принимаются все решения. Эти модели учатся на данных, выявляют закономерности и принимают решения. Но вот чем отличается объяснимый ИИ: вместо того, чтобы быть «черным ящиком», выдающим результаты, модели объяснимого ИИ позволяют нам визуально исследовать поведение модели.

Это дает вам возможность заглянуть под капот, чтобы понять, как ИИ пришел к выводу. Эта прозрачность укрепляет доверие, поскольку предприятия и частные лица могут убедиться, что ИИ принимает разумные решения. Объяснимые системы искусственного интеллекта могут быть полезны в сценариях, где важна ответственность, например, с беспилотным автомобилем.

Это возвращает нас к сути: объяснимый ИИ может революционизировать наши отношения с технологиями и повысить доверие к компаниям и отдельным лицам, но не освобождает нас от ответственности. Объяснимый ИИ использует методы, которые имитируют процессы принятия решений человеком, чтобы повысить его интерпретируемость.

Концепции интерпретируемости

Лица, принимающие решения, хотят знать, как делаются прогнозы, прежде чем они смогут внедрить ИИ. Концепции интерпретируемости помогают объяснить внутреннюю работу моделей ИИ, позволяя людям понять их. Но это не все; Объяснимый ИИ не только помогает нам понять, почему модели что-то делают, но и кто за это отвечает. Объяснимые модели ИИ обучаются путем включения методов объяснимости, которые используют простые текстовые описания для разъяснения поведения.

Системы XAI имитируют процессы принятия решений человеком, чтобы улучшить наше понимание базовых моделей. Хотя концепции, используемые для обучения данных, различаются, мы можем использовать примеры, чтобы разбить идею. Простым примером концепции интерпретируемости может быть правило, определяющее, как оценивать страховые претензии при недостаточном количестве данных.

Концепции представляют собой алгоритмы, такие как дерево решений, байесовские сети, LIME и теория игр. Если мы разберем методы ИИ дальше, то получим пять свойств:

- причинность – исследует причинно-следственные связи между переменными.

- Доверять — позволяет нам доверять модели ИИ и ее решению.

- Информативность – помогает нам понять модель, предоставляя информацию о процессе принятия решений.

- Переносимость – помогает модели ИИ передавать свои знания в новые области.

- Справедливость – учитывает такие аспекты справедливости, как расовые, гендерные или возрастные предубеждения.

Пользователи-люди

Человеческий фактор в технологии объяснимого ИИ.

Человеческий фактор в технологии объяснимого ИИ.Ни одна система ИИ не обходится без человеческого фактора. XAI предназначен для обеспечения прозрачности и подотчетности систем ИИ на благо людей. Речь идет не только о понимании данных и алгоритмов, но и о вере в то, что система делает то, для чего она предназначена.

Тем не менее, есть разрыв между пониманием и доверием; мы можем доверять разумному результату системы только в том случае, если понимаем ее принципы. Системы XAI помогают восполнить этот пробел, четко объясняя, как регулируются решения системы. Чтобы объяснить обоснование, давайте расширим принципы XAI.

Объяснимые принципы ИИ

Ранее мы упоминали, что люди используют концепции интерпретируемости для понимания XAI. В свою очередь, ИИ использует обучающие данные и этот мандат, чтобы объяснить себя — чтобы донести до конечного пользователя. Но что эти понятия означают на практике?

Модели ИИ должны предоставлять доказательства

Один из фундаментальных принципов XAI заключается в том, что искусственный интеллект должен предоставлять подтверждающие доказательства своих решений. Организации не могут полагаться на исключительно экспериментальный ИИ, разрозненные пилотные проекты или создавать изолированные системы ИИ в разрозненном виде. Почему это важно?

Представьте, что вы используете GPS. Если он говорит вам выбрать определенный маршрут, вы хотели бы знать, почему. Это самый быстрый маршрут или самый безопасный? Тот же принцип применим и к ИИ. Когда модель ИИ принимает решение, очень важно, чтобы она могла объяснить.

Эти доказательства помогают пользователям понять «почему» решение, создавая доверие и прозрачность. Это также позволяет нам проверить вывод, гарантируя его справедливость, непредвзятость и точность. Таким образом, предоставление доказательств не только улучшает производительность модели; он поддерживает надлежащее управление моделью.

Точные объяснения поведения модели

Принцип предоставления апостериорных объяснений поведения модели является краеугольным камнем XAI. Подумайте об этом так: система ИИ подобна новому члену команды. Если этот член команды примет решение или рекомендацию, вы захотите понять ход его мыслей. Точно так же, когда модель ИИ анализирует данные и генерирует результат, она должна четко объяснить свой вывод.

Прозрачность помогает пользователям понять «почему» решения ИИ, укрепляя доверие и позволяя принимать более обоснованные решения. Что еще более важно, точные объяснения позволяют выявлять и исправлять любые потенциальные проблемы или погрешности в обучающих данных. Речь идет не только о понимании того, что делает система, но и о том, чтобы убедиться, что то, что она делала, было правильным и справедливым.

Система ИИ должна давать «содержательные» объяснения

Предоставление «значимых» объяснений — фундаментальный аспект объяснимого ИИ. Но что делает объяснение «содержательным»? По сути, речь идет о предоставлении пользователю точной, понятной и практичной информации. Например, модель ИИ использует сложный алгоритм для принятия решения. Сложности этого алгоритма могут показаться слишком сложными для большинства пользователей.

Напротив, осмысленное объяснение превратило бы эту сложность в нечто более удобоваримое, что конечный пользователь может использовать для обоснования своих решений. Более того, эти объяснения должны быть адаптированы к контексту пользователя, отвечая на его вопросы. По сути, осмысленные объяснения делают ИИ больше, чем просто инструментом; они превращают его в искусственных интеллектуальных машин-партнеров, которые помогают пользователям принимать сложные решения с уверенностью и ясностью.

Система должна работать в пределах знаний

Принцип работы в пределах знаний имеет решающее значение для объяснимого ИИ. Давайте разберемся: системы ИИ имеют ограничения, как и люди. Они могут работать только на основе данных, на которых они были обучены, и алгоритмов, с которыми они были запрограммированы. Если ИИ примет решение за пределами этих ограничений, это может привести к неточным или ненадежным результатам. Итак, нам нужно признавать и уважать границы знаний систем ИИ.

Это не означает, что модели ИИ не могут адаптироваться — напротив, обучение является важной частью ИИ. Но это обучение должно управляться и контролироваться, чтобы ИИ оставался в пределах своих знаний. Этот принцип помогает поддерживать точность и надежность систем ИИ. Это также способствует доверию между пользователями, поскольку решения ИИ основаны на проверенных знаниях.

Почему объяснимый ИИ важен для всех?

Просить кого-либо доверять автономному рабочему процессу с самого начала — это большой прыжок веры. XAI является ответом на эту проблему: он позволяет пользователям отслаивать слои и обнаруживать интерпретируемое машинное обучение. Это также обеспечивает подотчетность и справедливость, повышая прозрачность и наглядность, но здесь мы просто обобщаем. Объяснимый ИИ важен, но есть много причин, по которым он важен.

Разница между моделями «черный ящик» и «белый ящик»

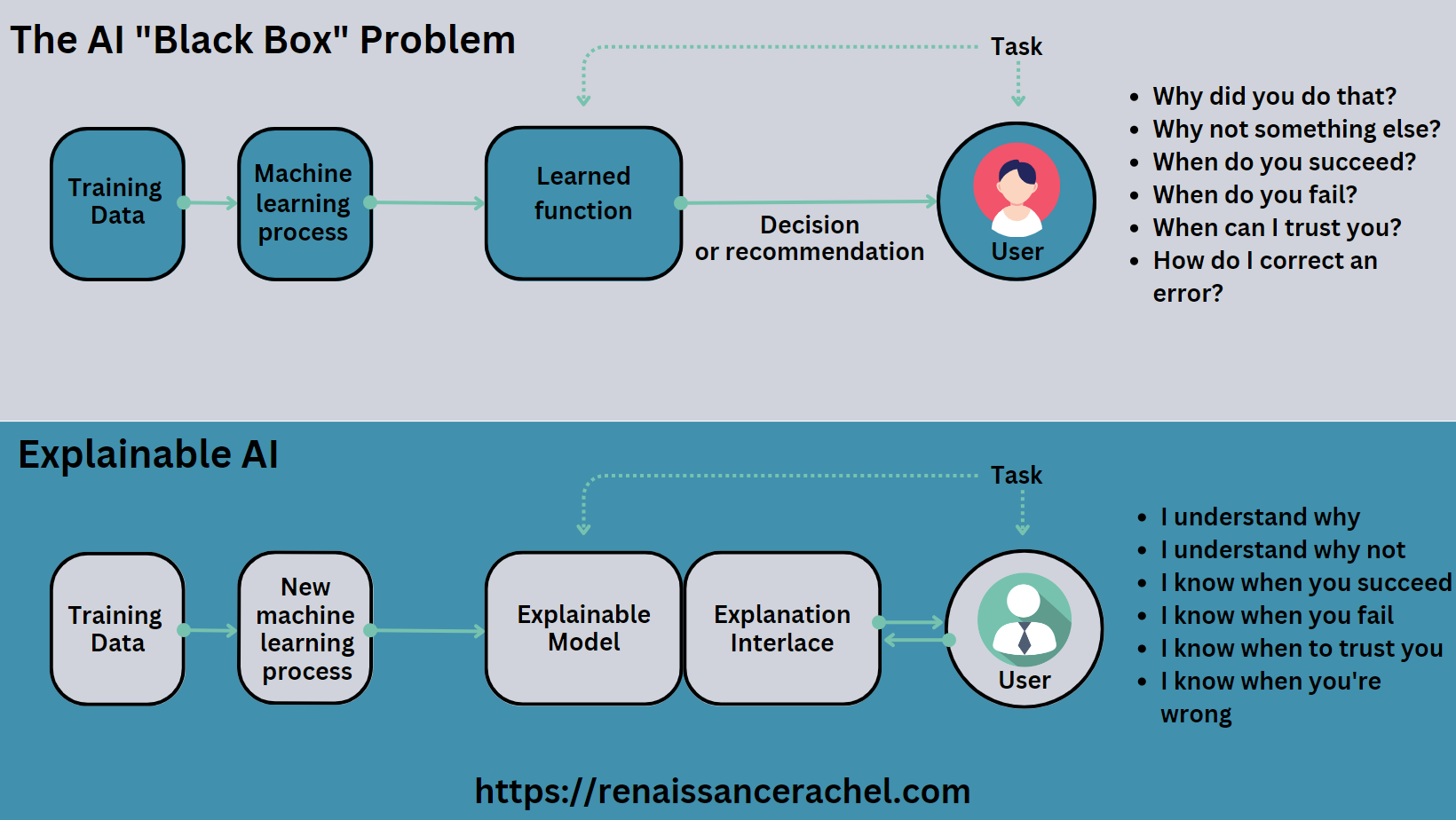

«Черный ящик» звучит так зловеще, не так ли? Это система ИИ, которая работает, но слишком сложна для объяснения. Это мешает людям доверять и проверять его результаты. А если ошибся? Как мы вообще узнаем, когда это удастся?

Сделать ИИ объяснимым проще, если убрать алгоритмы черного ящика.

Сделать ИИ объяснимым проще, если убрать алгоритмы черного ящика.Основное различие между моделями черного ящика и объяснимым искусственным интеллектом белого ящика заключается в том, что последний дает представление о том, как модель принимает решения. Используя изображение выше, вы можете видеть, что модели белого ящика соответствующим образом раскрывают свою внутреннюю работу. Вот почему Объяснимый ИИ так важен: чтобы преодолеть разрыв в доверии между нами, использующими ИИ, и теми, кто его разрабатывает.

Искусственный интеллект используется в чувствительных областях

Применение ИИ в чувствительных областях, таких как здравоохранение, правовые системы, военные действия и финансовые услуги, становится все более распространенным. Во время войны продвинутые дроны с искусственным интеллектом могут уничтожать людей без вмешательства человека. Хотя некоторые вооруженные силы обладают такими технологиями, они по-прежнему опасаются непредсказуемых результатов.

Они не решаются полагаться на системы, работу которых они не могут полностью понять. Самоуправляемые автомобили, такие как Tesla на автопилоте, обеспечивают комфорт для водителей, но несут с собой значительную ответственность. Мы должны понять, как машина справится с моральной дилеммой. Со временем системы искусственного интеллекта все больше влияют на нашу социальную жизнь.

Нейронные сети и алгоритмы ИИ для принятия автоматизированных решений нуждаются в доверии

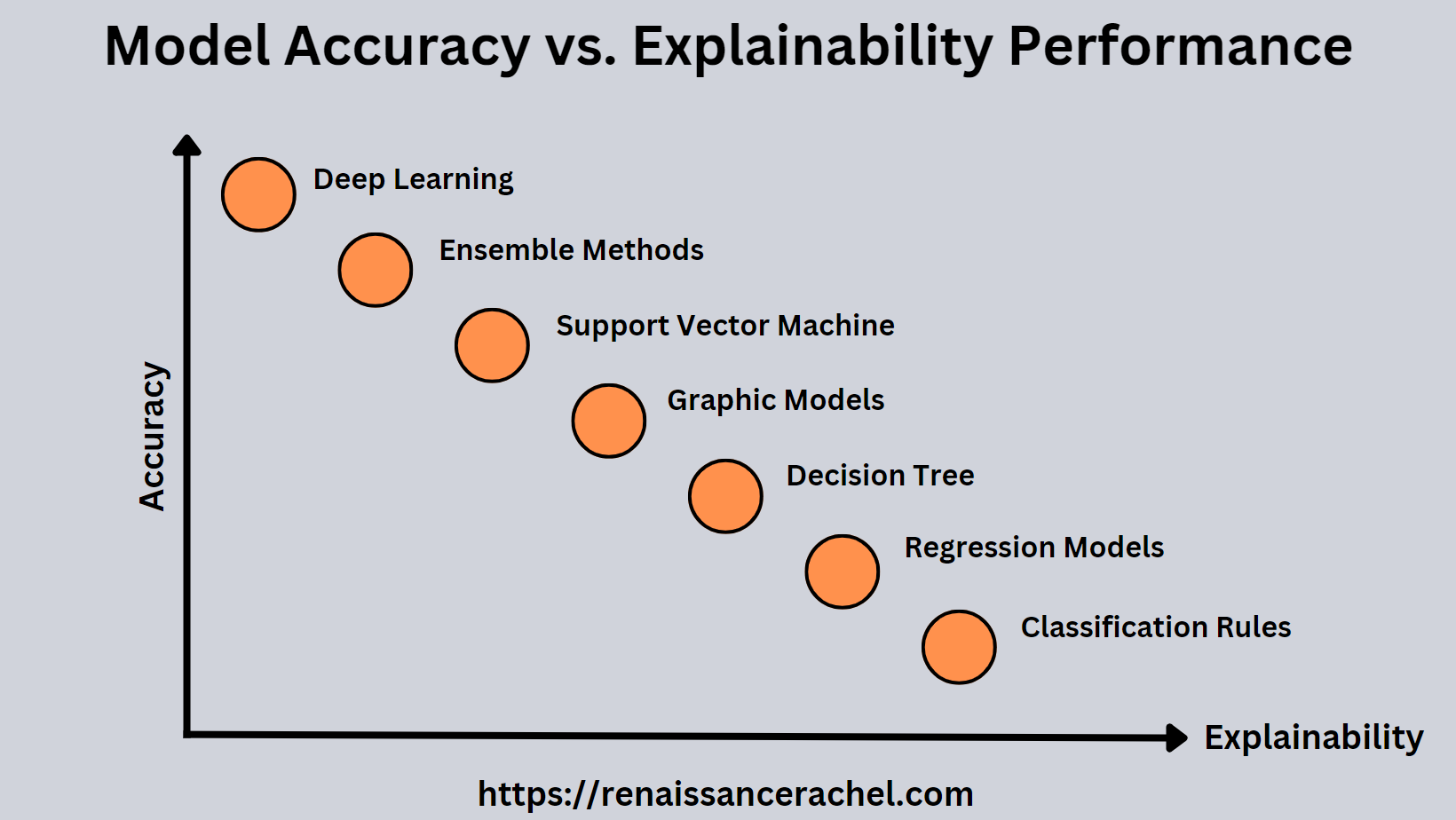

Нейронные сети и ИИ уже принимают автоматизированные решения, но вы можете задаться вопросом, почему алгоритмы машинного обучения проблематичны. На протяжении веков математики работали над традиционными алгоритмами машинного обучения. Эти алгоритмы были созданы задолго до компьютеров и очень интуитивно понятны.

Когда вы принимаете решения, используя один из этих традиционных алгоритмов, легко дать объяснения. Однако они достигают лишь определенного уровня точности предсказания. Таким образом, хотя наши стандартные алгоритмы имеют высокую объяснимость ИИ, они имели лишь ограниченный успех. Ограниченный успех не работает в здравоохранении, финансах или юриспруденции.

С тех пор машинное обучение претерпело революционные изменения, приведшие к появлению Deep Learning. Эта подобласть приложений ИИ стремится имитировать функции нашего мозга с помощью искусственных нейронных сетей. Благодаря превосходной вычислительной мощности и передовым платформам глубокого обучения с открытым исходным кодом мы можем разрабатывать сложные сети, обеспечивающие первоклассную точность.

К сожалению, нейронные системы трудно понять и обучать с миллиардами переменных, отсюда GPT-3, GPT-4 и так далее. На изображении выше показана корреляция между точностью и объяснимостью алгоритмов машинного обучения. Это показывает, что разработчики полагаются на модели глубокого обучения вместо традиционных алгоритмов в пользу точности. В результате снижается объяснимость моделей; однако мы нуждаемся в объяснимости больше, чем когда-либо.

Споры, связанные с ИИ, которые требуют разрешения, должны иметь объяснения

Правила требуют объяснимости из-за достижений в области прав и свобод человека за последние два столетия. Юридическая аргументация и рассуждение исследуют пределы объяснимости. Несмотря на то, что ИИ занял определенные должности, мы по-прежнему несем ответственность за предоставление объяснений и должны следовать тем же правилам, что и традиционные методы.

Кроме того, обязательная объяснимость также требуется действующими законами и правилами. Например, Общий регламент по защите данных (GDPR) в Европейском Союзе предусматривает «право на объяснение». GDPR требует объяснения логики ИИ, когда автоматизированные решения влияют на граждан.

Устранение предубеждений из самой модели ИИ требует объяснимости

Мы уже знаем, что люди исторически предвзяты; мы пытаемся устранить предубеждения в нашем обществе, но модели ИИ могут их запечь, если они не созданы на основе очищенных данных. Если разработчик обучает модель ИИ, используя дискриминационные исторические данные, модель может давать необъективные результаты.

Допустим, группа разработчиков обучила свою систему ИИ предвзятыми данными о коренных американцах; модель будет давать результаты, основанные на дискриминационной практике. Это было бы разрушительно для коренных американцев, поскольку способствовало бы несправедливому обращению. Эффекты могут быть перенесены и на другие группы меньшинств.

Модели машинного обучения могут создавать угрозы

Мы все слышали о разрушениях, которые ИИ может нанести миру — вспомните любой фильм об ИИ за последние 30 лет. И, честно говоря, они не так уж далеки от истины. Модели машинного обучения могут создать серьезные угрозы для общества, если их не остановить. почти половина из 731 ведущих исследователей ИИ считают, что искусственный интеллект человеческого уровня приведет к катастрофическим последствиям.

Теперь, когда понятно, почему Объяснимый ИИ важен, давайте поговорим о том, как он приносит пользу всем.

Каковы преимущества объяснимого ИИ?

Объяснимый ИИ имеет несколько преимуществ, в том числе принятие обоснованных решений, снижение рисков, улучшение управления, ускорение совершенствования системы и глобальное продвижение нового поколения ИИ.

Улучшает производительность модели

Объяснимый ИИ может значительно повысить производительность модели, обеспечивая интерпретируемость. Думайте об этом, как о проходе за кулисы концерта — наблюдайте, как все происходит за кулисами. В случае с ИИ вы можете понять, как модель представляет результаты.

Это понимание позволяет разработчикам точно настраивать модель, настраивать параметры или решать проблемы с точностью. Таким образом, модель может работать, принимая более точные решения. Кроме того, когда пользователи понимают, почему модель дает конкретные рекомендации, они будут доверять ей и использовать ее, повышая ее прогностическую силу и эффективность.

Это делает ИИ более надежным

Будем честны; может быть немного тревожно, когда машина выдает решение без объяснения причин. Это как получить совет от незнакомца, который говорит: «Поверь мне», но не говорит тебе, почему. С ответственным ИИ дело обстоит иначе.

Эти системы могут объяснить свои рассуждения, показывая нам, как они пришли к определенному выводу на основе проанализированных данных. Эта возможность «показать свою работу» помогает пользователям чувствовать себя более уверенно в решениях ИИ, что приводит к большему доверию и принятию. Ведь легче чему-то доверять, когда понимаешь, как это работает.

Привлекает к ответственности компании-разработчики ИИ

Объяснимый ИИ требует от компаний-разработчиков ИИ ответственности. Некоторые системы ИИ представляют собой «черные ящики», потому что они принимают решения, не объясняя, как и почему, но с объяснимым ИИ нет места для такой тайны. Эти системы могут четко и понятно объяснить процесс принятия решений.

Если система ИИ допускает ошибку или проявляет предвзятость, можно проследить и понять, почему это произошло. Такой уровень прозрачности заставляет компании-разработчики ИИ более тщательно подходить к процессу проектирования и обучения, обеспечивая честность, надежность и эффективность своих моделей. По сути, объяснимый ИИ подобен сторожевому псу, продвигающему подотчетность и этические нормы в индустрии ИИ.

Повышает производительность

Объяснимый ИИ меняет правила игры при повышении производительности. Вот как: это похоже на супер-умного, ультра-эффективного члена команды, который делает свою работу исключительно хорошо и объясняет свой процесс. Поскольку системы объяснимого ИИ могут анализировать огромные объемы данных и быстро принимать обоснованные решения, они могут значительно ускорить выполнение задач, от обслуживания клиентов до бизнес-аналитики. Но реальный прирост производительности происходит от их способности объяснить свой выбор.

Это означает, что вам не нужно тратить время на переоценку модели. Имея четкое представление об искусственном интеллекте, команды могут использовать его идеи в своих стратегиях и эффективно управлять своими рабочими процессами, помогая компаниям и отдельным лицам работать более эффективно.

Создает ценность для бизнеса и свойства, создающие ценность

Объяснимый ИИ также является мощным инструментом для создания ценности для бизнеса. Это улучшает процессы принятия решений, предоставляя четкую информацию, основанную на данных. Это означает, что предприятия могут принимать более обоснованные решения, что приводит к лучшим результатам и повышению прибыльности. Кроме того, XAI улучшает качество обслуживания клиентов, предоставляя персонализированные рекомендации, основанные на его способности анализировать данные и учиться на них.

Но, возможно, самое главное, XAI укрепляет доверие — бесценный актив в современном мире, управляемом данными. Когда клиенты, сотрудники и заинтересованные стороны понимают, как система ИИ принимает решения, они с большей вероятностью будут взаимодействовать с ней, что приведет к более тесным отношениям и большей ценности для бизнеса. Когда техническая группа может объяснить, как работает система ИИ, бизнес-группа может убедиться, что бизнес достигает своих целей. Объяснимый ИИ — это не просто инструмент для ведения бизнеса; это стратегический актив, который может способствовать росту и успеху приложений ИИ.

Снижает риски использования объяснимого ИИ

Объяснимый ИИ снижает риски, связанные с использованием ИИ. Часто «неизвестность» является фактором риска: если система искусственного интеллекта ставит неверный медицинский диагноз, а мы не понимаем, почему, предотвратить повторение той же ошибки невозможно. XAI меняет это, объясняя свои решения, позволяя нам исправлять любые проблемы с точностью модели и снижая риск будущих ошибок.

Более того, объяснимый ИИ снижает репутационные и юридические риски. Если система искусственного интеллекта несправедлива, это может нанести ущерб репутации компании или даже привести к судебному иску. Но благодаря прозрачности объяснимого ИИ эти риски значительно снижаются. По сути, объяснимый ИИ действует как надежный второй пилот, помогая с большей уверенностью ориентироваться в сложностях ИИ.

Как компании могут сделать ИИ более понятным?

Компании могут сделать ИИ более понятным, интегрировав этические принципы в свою деятельность; использование этики данных в повседневной жизни имеет важное значение. Это означает ответственное обращение с данными, обеспечение справедливости и прозрачность в отношении того, как модели ИИ интерпретируют и используют эти данные. Во-вторых, обучение имеет решающее значение — каждый в бизнесе должен понимать, почему объяснимый ИИ так важен.

Поиск подходящего таланта — еще один важный шаг. Было бы лучше, если бы у вас были люди, которые разбираются в ИИ и могут объяснить его работу понятным и доступным способом. Использование технологии искусственного интеллекта «Белый ящик» — единственный способ обеспечить прозрачность, поэтому предприятия должны инвестировать в такие технологии.

ИИ может выявлять и исправлять погрешности в данных или моделировать поведение, снижая риск получения неточных результатов. Наконец, важно понимать, какие проблемы решает объяснимый ИИ. Компании могут использовать свои возможности для достижения успеха, зная, что они могут сделать. По сути, сделать ИИ более объяснимым — значит интегрировать прозрачность, понимание и этику в основу вашей стратегии ИИ.

Что могут сделать люди, чтобы принять объяснимые концепции ИИ?

Люди могут принять концепции объяснимого ИИ несколькими способами. Во-первых, инвестиции в обучение имеют решающее значение. Понимание того, почему объяснимость важна, помогает людям использовать эти системы и доверять им. Доступно множество ресурсов, от онлайн-курсов до вебинаров, которые дают ценную информацию.

Во-вторых, полезно узнать о самой технологии объяснимости. Знание того, как работают модели «белого ящика», помогает людям понять решения ИИ. Это знание также полезно при выборе продуктов или услуг ИИ — вы захотите выбрать те, которые отдают предпочтение объяснимости.

Еще один важный шаг — быть в курсе законодательных и нормативных требований. Мир ИИ постоянно развивается, как и окружающие его законы. Следя за этими изменениями, люди всегда будут использовать ИИ этичным, справедливым и законным образом.

Наконец, крайне важно осознать, что внедрение методов объяснимого ИИ не только полезно, но и необходимо для достижения успеха. В мире, где ИИ становится все более распространенным, доверие к этим системам может дать людям преимущество в личной или профессиональной жизни. Таким образом, внедрение объяснимого ИИ — это не только понимание технологии, но и возможность оставаться впереди в быстро меняющемся мире.

Последние мысли

Объяснимый ИИ становится все более важным как для бизнеса, так и для частных лиц. Мы можем использовать их потенциал и улучшить процесс принятия решений, сделав системы ИИ более прозрачными, понятными и заслуживающими доверия. Организации должны создать процесс оценки рисков, чтобы оценить риски и юридические требования, связанные с объяснимостью для каждого варианта использования ИИ. Каждый вариант использования может иметь уникальные проблемы, и организации должны решать их надлежащим образом.

Люди должны инвестировать в обучение, чтобы лучше понять, почему объяснимый ИИ имеет значение. В конечном счете, объяснимый ИИ лежит в основе ответственного ИИ — это технология, которая способствует доверию и взаимопониманию между людьми и машинами. Интеграция XAI в нашу рутину позволяет нам лучше ориентироваться в постоянно меняющемся мире с большей безопасностью.